Голосовые ассистенты стали орудием хакерских атак на мобильные телефоны

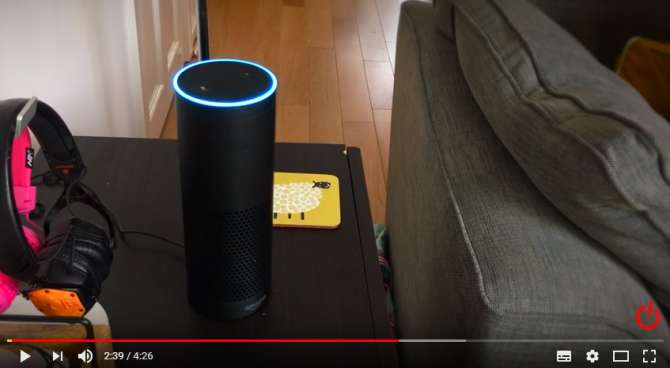

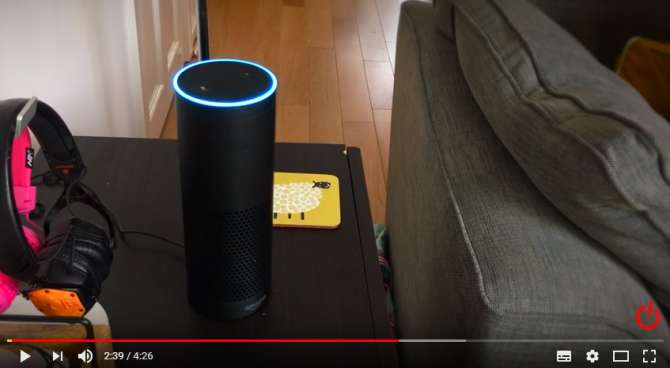

Об этом пишет The New York Times. Ученые отдают Google Assistant, Siri и Alexa команды, неразличимые для человеческого уха, об этом сообщает The New York Times. Эксперимент по интеграции команд в звуковые файлы провели в калифорнийском университете Беркли, а инженеры из Принстона и китайского университета Чжэцзян смогли заглушить ответы помощника так, чтобы пользователь не слышал его реакции на посторонние указания. Например, они могут вынудить смартфон либо умную колонку позвонить по определённому номеру, перевести деньги на счёт, открыть дверь, используя разумный дом, и прочее.

Как пишет печатное издание, при схожих аудиоатаках используются особенности распознавания речи человеком и машиной. Голосовые ассистенты Apple Siri, Amazon Alexa и Google Assistant оказались чувствительны к удаленному воздействию. Электронной системой создаются слова из букв, предложения из слов. В то же время, изменяя аудиофайл, можно заменить звуки, которые должны услышать ассистенты, на остальные, недоступные человеку для восприятия.

В Apple также напомнили, что для удачной передачи голосовой команды злоумышленнику придется вначале разблокировать iPhone либо iPad.

По утверждению ученых, пока технология не покидала стен лаборатории, однако это вопрос времени. Газета напоминает, что многие владельцы продукции Apple не устанавливают пароль. Они назвали технику DolphinAttack.

Следите за новостями в Telegram

👇 Поделитесь в вашей соцсети